想早起,那得早睡。但具体几点睡比较好,那还真是有科学依据的。

你是否总在早上被闹钟惊醒后,感觉浑身乏力、脑袋昏沉?又或者明明睡了七八个小时,白天却还是打不起精神?其实,这很可能不是你睡得不够,而是睡眠节奏出了问题。

其实睡眠是有周期的,在完整的睡眠周期结束后起床,精神是最饱满的。

但很多人对睡眠的理解还停留在 “睡够时间就行”,但事实上,睡眠是一场有规律的循环之旅。我们的睡眠由浅睡眠、深睡眠和 REM 睡眠(快速眼动睡眠)三个阶段组成,每个完整的循环大约持续 90-120 分钟。如果在循环中途醒来,哪怕总睡眠时间足够,也会觉得疲惫。

比如,成年人需要 7-9 小时睡眠,但有人睡了 8 小时却因为在深睡眠阶段被叫醒,反而比睡 6 小时但完整经历 4 个循环的人更累。

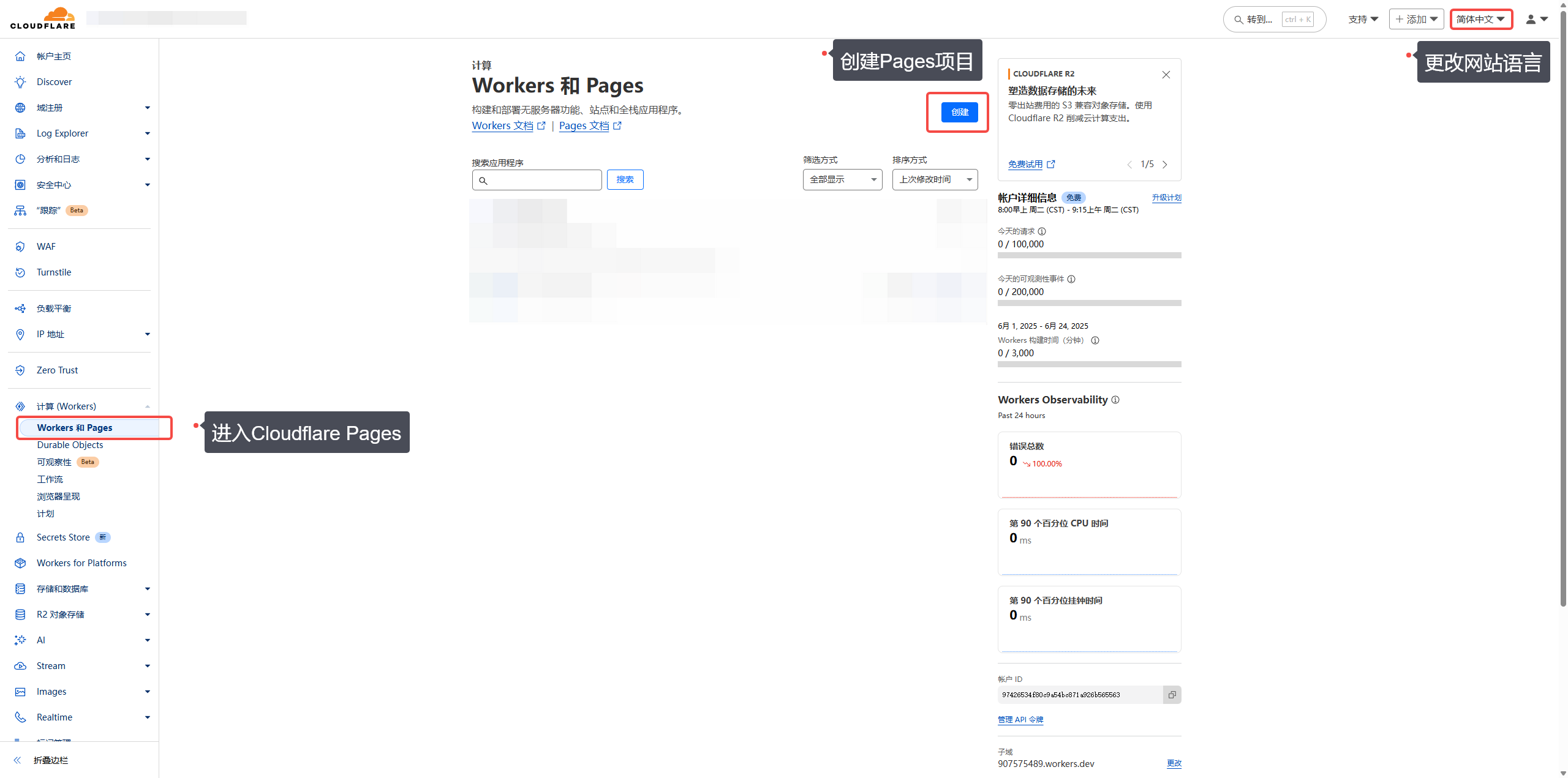

所以我们需要一款睡眠计算器来计算合适的睡觉时间,让睡眠高效又舒适。

睡眠计算器的核心作用,就是帮你避开 “打断循环” 的坑 —— 只要输入你的年龄和起床时间(或睡觉时间),它就能算出最适合的作息,确保你在睡眠周期的 “浅睡阶段” 醒来,起床后神清气爽。